본문

2026년 1월 「인공지능 발전과 신뢰 기반 조성 등에 관한 기본법」(이하 “AI 기본법”) 시행을 앞두고, 2025년 9월 과학기술정보통신부(이하 “과기정통부”)와 한국지능정보사회진흥원(NIA)이 하위법령의 구체적인 내용을 담은 'AI 기본법 하위법령집'을 공개했습니다. 기업들의 가장 큰 관심을 받는 부분은 '고영향 AI 판단 가이드 라인(안)'입니다.

AI 기본법은 AI 사업자가 제공하는 AI가 "사람의 생명, 신체의 안전 및 기본권에 중대한 영향을 미치거나 위험을 초래할 우려가 있는 경우” 이를 '고영향 AI'로 정의하고, 사업자에게 강화된 법적 책무를 부과합니다.

이번 가이드라인은 AI 사업자가 규제 대상 여부를 스스로 검토하고 예측 가능성을 높일 수 있도록 구체적인 판단 기준과 절차를 제시하고 있습니다. 본 뉴스레터에서는 가이드라인을 상세히 분석하고, 기업이 반드시 숙지해야 할 영역별 판단 기준과 사례를 정리했습니다.

1. 고영향 AI의 법적 정의와 2단계 판단 체계

2. 영역별 판단 기준

3. 시사점

1. 고영향 AI의 법적 정의와 2단계 판단 체계

AI 기본법 제2조 제4호에 따라, 고영향 AI는 ① 특정 영역에서 활용되고, ② 사람의 생명·신체·기본권에 중대한 영향을 미칠 우려가 있는 인공지능시스템을 의미합니다. 가이드라인은 이에 따라 다음의 2단계 판단 체계를 제시합니다. 두 단계를 모두 충족할 경우에만 고영향 AI로 분류됩니다.

① 1단계 조건인 10개 영역

AI 시스템이 AI 기본법 제2조 제4호 각 목에서 정한 다음 10개 영역 중 하나에서 활용되는지 여부를 먼저 판단합니다.

② 2단계 조건의 판단 기준

1단계 영역에 해당하더라도, 그 AI 시스템이 "사람의 생명, 신체의 안전 및 기본권에 중대한 영향을 미치거나 위험을 초래할 우려"가 있어야 고영향 AI로 판단됩니다. 가이드라인은 이 '중대성'을 판단하기 위한 5가지 세부 고려 사항을 제시합니다.

(1) 기능 중요도: AI 시스템이 기능하는 대상(인체, 차량, 전력공급시설 등)에 필수적인 기능을 독립적으로 수행할수록 고영향으로 분류

(2) 시스템 신뢰성: AI 시스템의 안전성, 오류 발생 빈도 등을 평가하여 신뢰도가 낮을수록 위험 발생 가능성이 증가하므로 고영향으로 분류

(3) 오작동 시 잠재적 위험성: AI 시스템이 오작동하는 경우를 상정할 때 치명적인 결과를 초래할 수 있는 시스템은 고영향으로 분류

(4) 데이터 정확성 및 처리 능력: AI 시스템의 데이터를 정확하게 수집·처리하여 올바른 결정을 내리는 능력을 평가, 의도치 않은 결과 도출 가능성이 높을수록 고영향으로 분류

(5) 자율성 및 의사결정 능력: AI 시스템이 사람의 개입 없이 자율적으로 의사결정을 내리는 정도를 평가하여 자율성이 클수록 고영향으로 분류

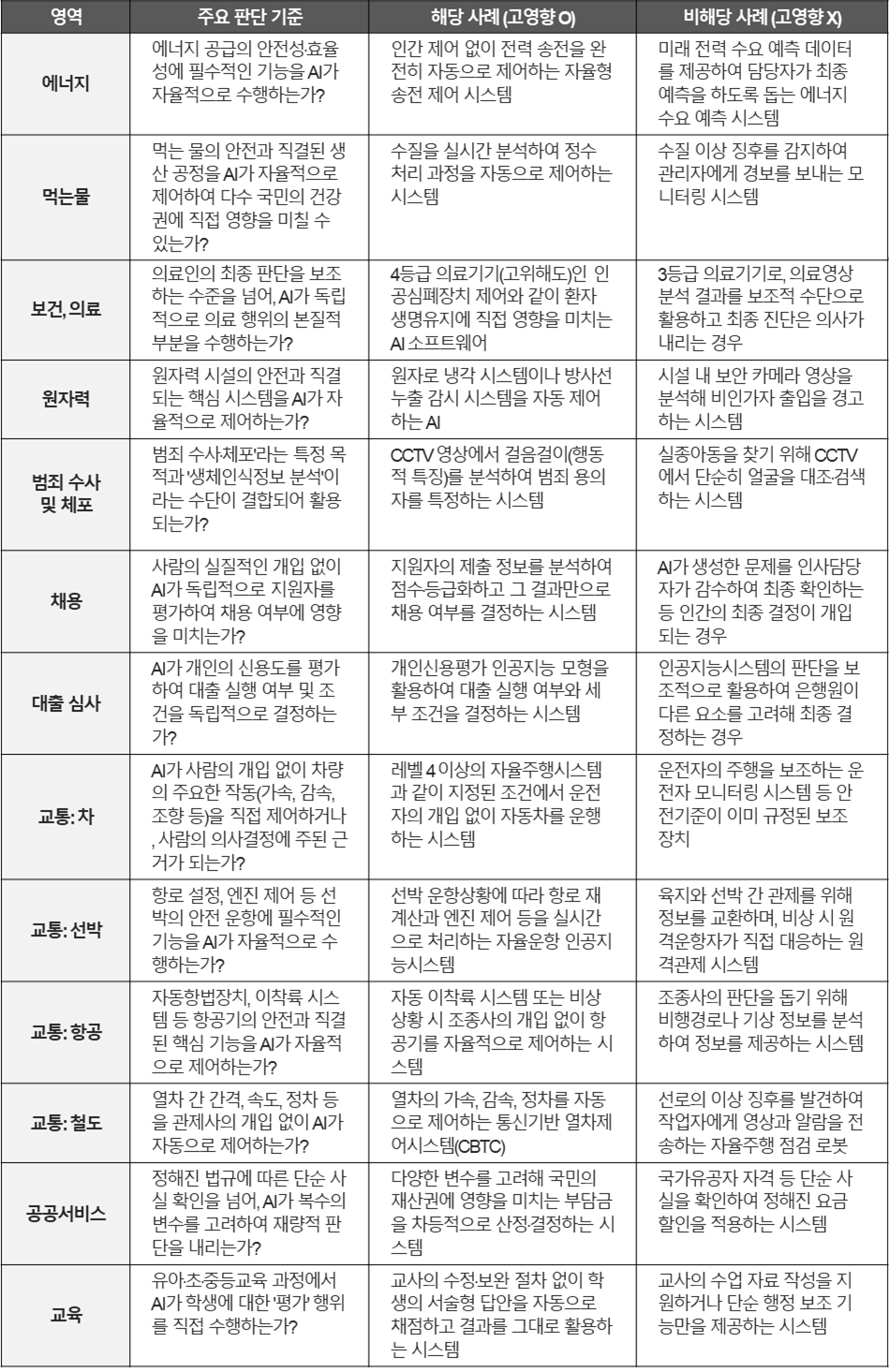

2. 영역별 판단 기준

가이드라인은 각 영역별로 고영향 AI를 판단하는 주요 기준과 사례를 공개하고 있습니다. 다음은 가이드라인 내용의 핵심을 요약하여 정리한 표입니다.

3. 시사점

자체적인 판단이 어렵거나 법적 불확실성이 높은 경계선상의 AI 시스템에 대해서는, 과기정통부에 '고영향 인공지능 해당 여부 확인을 요청'하는 절차(AI기본법 제33조)를 전략적으로 활용하여 규제 리스크를 사전에 해소하는 것이 바람직합니다. 특히 고영향 AI로 판단될 경우, AI기본법 제34조에 따른 사업자 책무(위험관리, 설명방안, 이용자 보호 등)가 부과되므로, 법 시행 전 관련 시스템에 대한 내부 컴플라이언스 체계를 선제적으로 구축할 필요가 있습니다.

화우 AI센터는 인공지능 산업에 전문성을 가진 전문가 및 유관기관에서 다양한 실무경험을 쌓은 전문인력으로 구성되어 있습니다. 인공지능 분야에 관한 모든 법률 문제에 신속하게 대응할 수 있도록 이슈를 선제적으로 안내하고, 그에 따른 적시 도움을 드리겠습니다. 이와 관련하여 문의사항이 있으신 경우 언제든지 연락하여 주시기 바랍니다.

- 관련 분야

- #AI센터